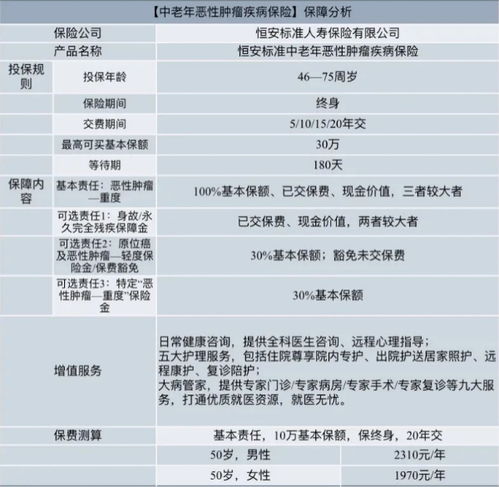

公布基于自研芯片的集群,约等于个

如果您希望可以时常见面,欢迎标星收藏哦~

来源:内容由半导体行业观察(ID:icbank)编译自tomshardware,谢谢。

刚刚启动了孟菲斯超级集群的埃隆·马斯克现在分享了使用自己开发的Dojo人工智能加速器的超级计算机集群的图片。他还在特斯拉财报电话会议上宣布,由于Nvidia的GPU价格昂贵,他将加倍投入Dojo的开发和部署。

除了在田纳西州开设xAI工厂(该工厂的目标是在单一架构上安装100,000个NvidiaH100GPU)之外,马斯克还表示,他将在年底前让DojoD1投入运行。正如马斯克所说,它的处理能力将相当于8,000个NvidiaH100芯片,这“不算庞大,但也不算小事”。

马斯克于2021年首次推出DojoD1芯片,性能目标为322TeraFLOP。随后,去年8月,公布基于自研芯片的集群,约等于个特斯拉被发现正在招聘数据中心高级工程项目经理,这通常是任何组织在规划自己的数据中心时要采取的第一步。特斯拉还在次月将DojoD1的订单量翻了一番,这表明它对其性能充满信心。

据报道,到2024年5月,Dojo处理器已投入量产。现在,Dojo芯片似乎已经进入美国并到达Elon的手中,昨天他在数据中心分享了Dojo超级计算机的照片。

Dojo芯片是具有5×5阵列的晶圆系统处理器。这意味着其25个超高性能芯片使用台积电的集成扇出(InFO)技术互连,因此它们可以充当单个处理器,并且比类似的多处理器机器更高效地运行。

台积电为特斯拉生产Dojo芯片,马斯克将与由Nvidia提供支持的孟菲斯超级集群一起运行这些芯片。然而,虽然田纳西州的工厂归xAI所有,主要用于训练Grok,但Dojo芯片更适合人工智能机器学习和视频训练,尤其是因为它们将用于根据从特斯拉汽车收集的视频数据训练特斯拉的全自动驾驶技术。

当马斯克把他手头上的所有芯片加在一起时,他表示到2024年底,他将拥有9万块NvidiaH100芯片、4万块NvidiaAI4和DojoD1晶圆。如此强大的算力,可见这位亿万富翁在人工智能领域投入了多少精力和资源。

全球最强的AI集群

日前,科技巨头埃隆·马斯克在Twitter/X上宣称,他已经启动了“世界上最强大的人工智能训练集群”,他将利用该集群打造自称“今年12月前,按各指标衡量,世界上最强大的人工智能”。今天,xAI的孟菲斯超级集群开始使用100,000个液冷NvidiaH100GPU进行人工智能训练,这些GPU通过单个RDMA(远程直接内存访问)结构连接。

马斯克是否亲自按下开关来启动超级集群似乎不太可能,因为值得注意的是,它在美国中部夏令时间凌晨4点20分开始了这项艰巨的任务,但正如你在上图看到的,他确实帮助了光纤技术人员。

5月份,我们报道了马斯克计划在2025年秋季之前开设超级计算工厂的雄心。当时,马斯克急于开始超级集群的开发,因此必须购买当前一代的“Hopper”H100GPU。这似乎表明这位科技巨头没有耐心等待H200芯片的推出,更不用说即将推出的基于Blackwell的B100和B200GPU。尽管人们预计较新的NvidiaBlackwell数据中心GPU将在2024年底之前发货,但情况仍然如此。

那么,如果超级计算工厂预计将于2025年秋季开业,那么今天的新闻是否意味着该项目提前一年实现?确实可能提前了,但更有可能的是,今年早些时候接受路透社和TheInformation采访的消息人士在项目时间方面说错了话或被错误引用了。随着xAI孟菲斯超级集群已经启动并运行,关于xAI为什么不等待更强大或下一代GPU的问题得到了解答。

超微提供了大部分硬件,该公司首席执行官也在马斯克的帖子下发表评论,称赞该团队的执行力。此前,梁最近对马斯克的液冷AI数据中心大加赞赏。

在后续推文中,马斯克解释说,新的超级集群将“训练世界上所有指标中最强大的人工智能”。从之前的意向声明中,我们假设xAI的100,000个H100GPU安装的功能现在将用于Grok3训练。马斯克表示,改进后的LLM应该“在今年12月”完成训练阶段。

如果要将孟菲斯超级集群的计算资源放在某种背景下来看,当然,从规模上看,新的xAI孟菲斯超级集群在GPU马力方面轻松超越了最新Top500榜单上的任何一台超级计算机。世界上最强大的超级计算机,如Frontier、Aurora和MicrosoftEagle(14,400个NvidiaH100GPU),似乎都远远落后于xAI机器。

参考链接

https://www.tomshardware.com/tech-industry/artificial-intelligence/elon-musk-reveals-photos-of-dojo-d1-supercomputer-cluster-roughly-equivalent-to-8000-nvidia-h100-gpus-for-ai-training点这里加关注,锁定更多原创内容